Matematika A2a 2008/4. gyakorlat

Mozo (vitalap | szerkesztései) (→Lineáris leképezések folytonossága) |

Mozo (vitalap | szerkesztései) (→Többváltozós függvény szélsőértéke) |

||

| (egy szerkesztő 12 közbeeső változata nincs mutatva) | |||

| 1. sor: | 1. sor: | ||

:''Ez az szócikk a [[Matematika A2a 2008]] alszócikke.'' | :''Ez az szócikk a [[Matematika A2a 2008]] alszócikke.'' | ||

| − | == | + | ==Teljes differenciálhatóság, gyakorlás== |

| − | + | ||

| − | + | ||

| − | + | '''1.''' Hol deriválható? | |

| + | :<math>f(x,y)=\sqrt[3]{x^4+y^4}</math> | ||

| − | + | '''2.''' Hol deriválható? | |

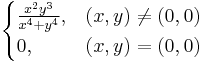

| − | + | :<math>\begin{cases} | |

| − | + | \frac{x^2y^3}{x^4+y^4}, & (x,y)\neq (0,0)\\ | |

| − | + | 0, & (x,y)=(0,0) | |

| − | + | \end{cases} | |

| − | + | ||

| − | :<math> | + | |

| − | \ | + | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

</math> | </math> | ||

| − | + | ==Iránymenti deriválhatóság és differenciálhatóság== | |

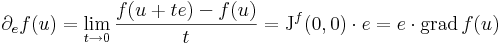

| + | Ha e tetszőleges egységvektor, akkor | ||

| + | :<math>\lim\limits_{t\to 0}\frac{f(u+te)-f(u)}{t}=\partial_{e}f(u)=[\mathrm{grad}\,f(u)]\cdot e=[\nabla f(u)]\cdot e</math> | ||

| − | |||

| − | |||

| − | |||

| − | + | '''Példa.''' | |

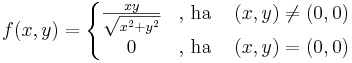

| + | :<math>f(x,y)=\left\{\begin{matrix}\frac{xy}{\sqrt{x^2+y^2}}& \mbox{, ha }&(x,y)\ne (0,0)\\ | ||

| + | 0&\mbox{, ha }&(x,y)=(0,0)\end{matrix}\right.</math> | ||

| − | + | Ekkor | |

| + | :<math>\mathrm{J}^f(0,0)=[0, 0]\,</math> | ||

| − | ''' | + | Ha tehát differenciálható, akkor az '''iránymenti derivált'''ak (Gateau-deriváltak) is léteznek (e egységvektor): |

| − | + | ||

| − | + | ||

| − | + | :<math>\partial_ef(u)=\lim\limits_{t\to 0}\frac{f(u+te)-f(u)}{t}=\mathrm{J}^f(0,0)\cdot e=e\cdot\mathrm{grad}\,f(u)</math> | |

| − | :<math> | + | |

| − | \ | + | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

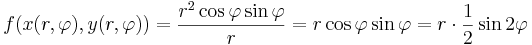

| − | + | Ám, polárkoordinátákra áttérve: | |

| − | + | :<math>f(x(r,\varphi),y(r,\varphi))=\frac{r^2\cos\varphi\sin\varphi}{r}=r\cos\varphi\sin\varphi=r\cdot \frac{1}{2}\sin 2\varphi</math> | |

| − | :<math> | + | φ = π/4-et és π + π/4-et véve a vetületfüggvény a |

| − | + | :<math>t\mapsto\frac{1}{2}|t|</math>, | |

| − | + | ami nem differenciálható a 0-ban. | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | :<math>\ | + | |

| − | + | ||

| − | + | Illetve nézzük meg a (3,4) vektor mentén! | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | '''Megjegyzés.''' Persze abból, hogy az összes iránymenti derivált létezik, abból nem következik, hogy a függvény totálisan deriválható. | |

| − | + | ==Szélsőérték szükséges feltétele== | |

| − | + | ||

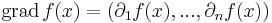

| − | '' | + | Egyelőre állapodjunk meg abban, hogy gradiensnek nevezzük a következő többváltozós vektorértékű függvényt: ha ''f'': '''R'''<sup>n</sup> <math>\supset\!\to</math> '''R''' parciálisan differenciálható, akkor |

| − | :<math> | + | :<math>\mathrm{grad}\,f(x)=(\partial_1f(x),...,\partial_nf(x))</math> |

| − | + | mely lényegében az ''f'' elsőrendű parciális deriváltjaiból képezett vektor. | |

| − | + | ||

| − | + | Később a gradienst egy kissé másképp fogjuk értelmezni és amit most definiáltunk, az a gradiens sztenderd bázisbeli mátrixa lesz (adott pontra vonatkozóan). | |

| − | |||

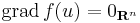

| − | + | '''Tétel''' - ''Fermat-féle szésőértéktétel'' - Legyen ''f'': '''R'''<sup>n</sup> <math>\supset\!\to</math> '''R''', ''u'' ∈ int Dom(''f''), ''f'' parciálisan differenciálható ''u''-ban. | |

| + | :Ha ''u''-ban ''f''-nek (lokális) szélsőértéke van, akkor | ||

| + | ::<math>\mathrm{grad}\,f(u)=0_{\mathbf{R}^n}\,</math> | ||

| + | ''U.is:'' minden ''i''-re az ''i''-edik parciális függvénynek szélsőértéke van ''u''<sub>i</sub>-ben, így az egyváltozós Fermat-tétel miatt ezeknek a deriváltja ''u''<sub>i</sub>-ben 0, így a gradiens értéke 0. | ||

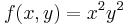

| − | :<math> | + | ====Példa==== |

| − | + | :<math>f(x,y)=x^2y^2\,</math> | |

| − | :<math>\ | + | Ennek gradiense: |

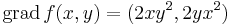

| − | + | :<math>\mathrm{grad}\,f(x,y)=(2xy^2,2yx^2)</math> | |

| − | :<math>\ | + | Az |

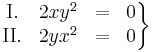

| − | + | :<math>\left. | |

| − | + | \begin{matrix} | |

| + | \mathrm{I.} & 2xy^2 & = & 0\\ | ||

| + | \mathrm{II.} & 2yx^2 & = & 0\\ | ||

| + | \end{matrix} | ||

| + | \right\}</math> | ||

| + | egyenletrendszer megoldásai: ''x'' = 0, ''y'' tetszőleges ill. ''y'' = 0 és ''x'' tetszőleges. A szélsőértékek helyei csak ezek közül kerülhetnek ki és ezek valóban szélsőértékek is, mert ezeken a függvény 0-t vesz fel, ami a lehetséges legkisebb értéke. | ||

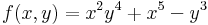

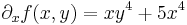

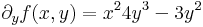

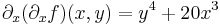

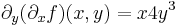

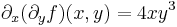

| + | ==Magasabbrendű parciális deriváltak== | ||

| + | Ha ''f'' parciálisan deriválható, akkor ∂<sub>1</sub>''f'' és ∂<sub>2</sub>''f'' szintén kétváltozós függvények (a pontonként a deriváltak, mint függvényértékek értelmezésével) és érdeklődhetünk ezek parciális differenciálhatóságuk iránt. Például: | ||

| − | + | :<math>f(x,y)=x^2y^4+x^5-y^3\,</math> | |

| + | :<math>\partial_xf(x,y)=xy^4+5x^4</math> | ||

| + | :<math>\partial_yf(x,y)=x^24y^3-3y^2</math> | ||

| − | + | :<math>\partial_x(\partial_xf)(x,y)=y^4+20x^3</math> | |

| − | :<math> | + | :<math>\partial_y(\partial_yf)(x,y)=12x^2y^2-6y^2</math> |

| − | + | :<math>\partial_y(\partial_xf)(x,y)=x4y^3</math> | |

| − | + | :<math>\partial_x(\partial_yf)(x,y)=4xy^3</math> | |

| − | :<math> | + | |

| − | + | ||

| − | 2 | + | |

| − | + | ||

| − | + | ||

| − | :<math>\ | + | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | :<math> | + | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | És valóban: | |

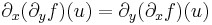

| − | + | '''Tétel.''' (Young-tétel) Ha a másodrendű parciális deriváltak léteznek az ''u'' egy környezetében és folytonosak az ''u'' pontban, akkor az ''u''-beli vegyes másodrendű parciláis deriváltak egyenlőek: | |

| − | ''' | + | :<math>\partial_x(\partial_y f)(u)=\partial_y(\partial_x f)(u)</math> |

| − | + | Azaz az alábbi, úgy nevezett Hesse-mátrix szimmetrikus: | |

| + | :<math>H^f(u)=\begin{bmatrix} | ||

| + | \cfrac{\partial^2 f(u)}{\partial x^2} & \cfrac{\partial^2 f(u)}{\partial y\partial x}\\\\ | ||

| + | \cfrac{\partial^2 f(u)}{\partial x\partial y} & \cfrac{\partial^2 f(u)}{\partial y^2} | ||

| + | \end{bmatrix}</math> | ||

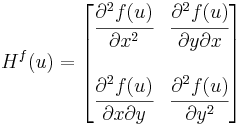

| − | + | '''Feladat.''' Az a kitétel, hogy az ''u''-ban a másodrenrű parciláis deriváltak folytonosak, nem hagyható el, ugyanis. Legyen | |

| − | : <math> | + | :<math>f(x,y)=\left\{\begin{matrix} |

| − | + | 0,& \mbox{ ha }(x,y)=(0,0)\\ | |

| + | \frac{xy(x^2-y^2)}{x^2+y^2},& \mbox{ ha }(x,y)\ne(0,0) | ||

| + | \end{matrix}\right.</math> | ||

| + | Ekkor a 0-ban nem egyenlő a két vegyes parciális derivált. | ||

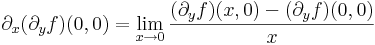

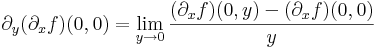

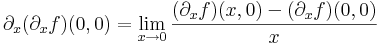

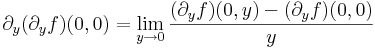

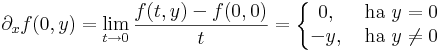

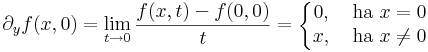

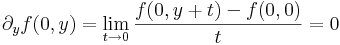

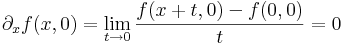

| − | + | Tekintsük a parciális deriváltakat: | |

| − | :<math>\ | + | :<math>\partial_x(\partial_yf)(0,0)=\lim\limits_{x\to 0}\frac{(\partial_yf)(x,0)-(\partial_yf)(0,0)}{x}</math> |

| + | :<math>\partial_y(\partial_xf)(0,0)=\lim\limits_{y\to 0}\frac{(\partial_xf)(0,y)-(\partial_xf)(0,0)}{y}</math> | ||

| + | :<math>\partial_x(\partial_xf)(0,0)=\lim\limits_{x\to 0}\frac{(\partial_xf)(x,0)-(\partial_xf)(0,0)}{x}</math> | ||

| + | :<math>\partial_y(\partial_yf)(0,0)=\lim\limits_{y\to 0}\frac{(\partial_yf)(0,y)-(\partial_yf)(0,0)}{y}</math> | ||

| + | Ehhez tehát elegendő kiszámítani a következő föggvényeket: y <math>\mapsto</math> (∂<sub>x</sub>f)(0,y), x <math>\mapsto</math> (∂<sub>y</sub>f)(x,0). Ehhez a parciális deriváltak: | ||

| + | :<math>\partial_xf(0,y)=\lim\limits_{t\to 0}\frac{f(t,y)-f(0,0)}{t}=\left\{\begin{matrix} | ||

| + | 0,& \mbox{ ha }y=0\\ | ||

| + | -y,& \mbox{ ha }y\ne 0 | ||

| + | \end{matrix}\right.</math> | ||

| + | :<math>\partial_yf(x,0)=\lim\limits_{t\to 0}\frac{f(x,t)-f(0,0)}{t}=\left\{\begin{matrix} | ||

| + | 0,& \mbox{ ha }x=0\\ | ||

| + | x,& \mbox{ ha }x\ne 0 | ||

| + | \end{matrix}\right.</math> | ||

| + | :<math>\partial_yf(0,y)=\lim\limits_{t\to 0}\frac{f(0,y+t)-f(0,0)}{t}=0</math> | ||

| + | :<math>\partial_xf(x,0)=\lim\limits_{t\to 0}\frac{f(x+t,0)-f(0,0)}{t}=0</math> | ||

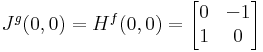

| − | + | Megjegyezzük, hogy a g=(∂<sub>x</sub>f,∂<sub>y</sub>f) függvény (0,0)-beli parciális deriváltjai nem lehetnek folytonosak, mert ott a függvény nem totálisan diffható. Ugyanis a g Jacobi-mátrixa: | |

| − | :<math> | + | :<math>J^g(0,0)=H^f(0,0)=\begin{bmatrix} |

| − | + | 0 & -1\\ | |

| + | 1 & 0 | ||

| + | \end{bmatrix}</math> | ||

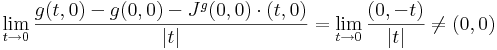

| + | ami a 90˚-os forgatás. Ekkor a g-t a (t,0) vektorral közelítve a 0-ba: | ||

| + | :<math>\lim\limits_{t\to 0}\frac{g(t,0)-g(0,0)-J^g(0,0)\cdot (t,0)}{|t|}=\lim\limits_{t\to 0}\frac{(0,-t)}{|t|}\ne (0,0)\,</math> | ||

| + | márpedig ha g minden parciális deriváltja folytonos lenne a (0,0)-ban, akkor g totálisan is deriválható lenne. | ||

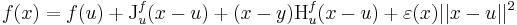

| − | + | ==Többváltozós függvény szélsőértéke== | |

| − | :<math> | + | :<math>f(x)=f(u)+\mathrm{J}_u^f(x-u)+(x-y)\mathrm{H}^f_u(x-u)+\varepsilon(x)||x-u||^2</math> |

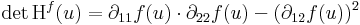

| + | ===Másodikderivált-próba=== | ||

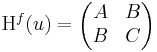

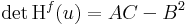

| + | Kétszer differenciálható függvényre vonatkozóan megfogalmazhatjuk a lokális maximum és minimum létezésének elégséges feltételét. Csak a kétváltozós függvényekkel foglalkozunk. Tegyük fel, hogy grad ''f''(u) = 0 és H<sup>f</sup>(u) az ''f'' Hesse-mátrixa | ||

| + | # ha det H<sup>f</sup>(u) > 0 és ∂<sub>11</sub>''f''(''u'') < 0, akkor ''f''-nek ''u''-ban '''maximuma''' van | ||

| + | # ha det H<sup>f</sup>(u) > 0 és ∂<sub>11</sub>''f''(''u'') > 0, akkor ''f''-nek ''u''-ban '''minimuma''' van | ||

| + | # ha det H<sup>f</sup>(u) < 0, akkor ''f''-nek biztosan nincs szélsőértéke, ún. '''nyeregpont'''ja van | ||

| + | # ha det H<sup>f</sup>(u) = 0, akkor a próba nem járt sikerrel, azaz további vizsgálatokat igényel annak eldöntése, hogy ''u'' szélsőérték hely-e. | ||

| + | ''Megjegyzések.'' Mivel kétváltozós esetben | ||

| + | :<math>\mathrm{det}\,\mathrm{H}^f(u)=\partial_{11}f(u)\cdot \partial_{22}f(u)-(\partial_{12}f(u))^2</math> | ||

| + | ezért olyan eset nem létezik, hogy det H<sup>f</sup>(u) > 0 és ∂<sub>11</sub>''f''(''u'') = 0. | ||

| − | + | Világos, hogy a második derivált tipikusan azoknál a függvényeknél jár sikerrel, melyeket egy másodfokú függvény közelít a legjobban (aszimptotikusan másodfokúak). Ha a függvény ennél magasabb fokú, akkor a második deriváltak eltűnnek és a Hesse-mártix elfajul (vagy legalább is tipikusan elfajul). | |

| − | : <math> | + | |

| − | + | Ha tehát | |

| − | + | :<math>\mathrm{H}^{f}(u)=\begin{pmatrix} | |

| − | + | A & B \\ | |

| + | B & C | ||

| + | \end{pmatrix}</math>, akkor <math>\mathrm{det\,H}^{f}(u)=AC - B^2 </math>, | ||

| + | és így a tipikus példák a következők. | ||

| − | === | + | ====Példák==== |

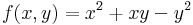

| − | + | '''1.''' Ha B kicsi, azaz az AC-hez képest kis abszolútrétékű szám, akkor a szélsőérték irányába mozdul el a feladat. | |

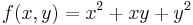

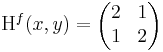

| − | :<math> | + | :<math>f(x,y)=x^2+xy+y^2\,</math> |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | Ekkor grad ''f'' = ( 2x + y , 2y + x ) és | |

| − | :<math>\ | + | :<math>\mathrm{H}^{f}(x,y)=\begin{pmatrix} |

| − | + | 2 & 1 \\ | |

| − | + | 1 & 2 | |

| − | + | \end{pmatrix}</math> | |

| + | azaz 4 - 1 = 3 > 0 és 2 > 0 miatt minimum. | ||

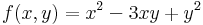

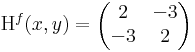

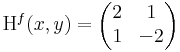

| + | '''2.''' Ha |B| nagy (azaz AC-hez képest nagy), akkor a bizonyosan nemszélsőérték irányába. | ||

| + | :<math>f(x,y)=x^2-3xy+y^2\,</math> | ||

| − | + | Ekkor grad ''f'' = ( 2x + -3y , 2y + -3x ) és | |

| − | :<math>\ | + | :<math>\mathrm{H}^{f}(x,y)=\begin{pmatrix} |

| − | + | 2 & -3 \\ | |

| + | -3 & 2 | ||

| + | \end{pmatrix}</math> | ||

| + | azaz 4 - 9 = -5 < 0 miatt nincs szélsőérték: nyeregpont. | ||

| − | ''' | + | '''3.''' Negatív A és C-re és kis B-re: |

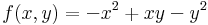

| − | + | :<math>f(x,y)=-x^2+xy-y^2\,</math> | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | : | + | |

| − | :<math>f(x | + | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | Ekkor grad ''f'' = ( -2x + 3y , -2y + 3x ) és | |

| − | + | :<math>\mathrm{H}^{f}(x,y)=\begin{pmatrix} | |

| + | -2 & 1 \\ | ||

| + | 1 & -2 | ||

| + | \end{pmatrix}</math> | ||

| + | azaz 4 - 1 = 3 > 0 és -2 < 0 miatt maximum. | ||

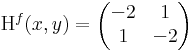

| − | + | '''4.''' Ha A és C előjele ellenkező, akkor rögtön következik, hogy nincs sz.é. | |

| − | + | :<math>f(x,y)=x^2+xy-y^2\,</math> | |

| − | + | ||

| − | :<math> | + | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | ''' | + | Ekkor grad ''f'' = ( 2x + y , -2y + x ) és |

| + | :<math>\mathrm{H}^{f}(x,y)=\begin{pmatrix} | ||

| + | 2 & 1 \\ | ||

| + | 1 & -2 | ||

| + | \end{pmatrix}</math> | ||

| + | azaz -4 - 1 = -5 < 0 azaz nyeregpont. | ||

| − | + | '''5.''' Atipikus eset, ha AC = B<sup>2</sup>. Ekkor nem jár sikerrel a próba: | |

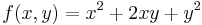

| − | + | :<math>f(x,y)=x^2+2xy+y^2\,</math> | |

| − | + | ||

| − | : | + | |

| − | + | ||

| + | Ekkor grad ''f'' = ( 2x + 2y , 2y + 2x ) és | ||

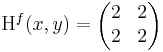

| + | :<math>\mathrm{H}^{f}(x,y)=\begin{pmatrix} | ||

| + | 2 & 2 \\ | ||

| + | 2 & 2 | ||

| + | \end{pmatrix}</math> | ||

| + | azaz 4 - 4 = 0, azaz határozatlan eset. | ||

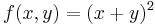

| + | De tudjuk, hogy | ||

| + | :<math>f(x,y)=(x+y)^2\,</math> | ||

| + | ami pontosan akkor minimális, ha x = -y, azaz ezeken a helyeken van szélsőérték. | ||

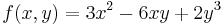

| + | '''6.''' | ||

| + | :<math>f(x,y)=3x^2-6xy+2y^3\,</math> | ||

| + | '''7.''' | ||

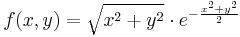

| + | :<math>f(x,y)=\sqrt{x^2+y^2}\cdot e^{-\frac{x^2+y^2}{2}}\,</math> | ||

<center> | <center> | ||

A lap jelenlegi, 2017. február 27., 11:49-kori változata

- Ez az szócikk a Matematika A2a 2008 alszócikke.

Tartalomjegyzék |

Teljes differenciálhatóság, gyakorlás

1. Hol deriválható?

2. Hol deriválható?

Iránymenti deriválhatóság és differenciálhatóság

Ha e tetszőleges egységvektor, akkor

Példa.

Ekkor

Ha tehát differenciálható, akkor az iránymenti deriváltak (Gateau-deriváltak) is léteznek (e egységvektor):

Ám, polárkoordinátákra áttérve:

φ = π/4-et és π + π/4-et véve a vetületfüggvény a

,

,

ami nem differenciálható a 0-ban.

Illetve nézzük meg a (3,4) vektor mentén!

Megjegyzés. Persze abból, hogy az összes iránymenti derivált létezik, abból nem következik, hogy a függvény totálisan deriválható.

Szélsőérték szükséges feltétele

Egyelőre állapodjunk meg abban, hogy gradiensnek nevezzük a következő többváltozós vektorértékű függvényt: ha f: Rn  R parciálisan differenciálható, akkor

R parciálisan differenciálható, akkor

mely lényegében az f elsőrendű parciális deriváltjaiból képezett vektor.

Később a gradienst egy kissé másképp fogjuk értelmezni és amit most definiáltunk, az a gradiens sztenderd bázisbeli mátrixa lesz (adott pontra vonatkozóan).

Tétel - Fermat-féle szésőértéktétel - Legyen f: Rn  R, u ∈ int Dom(f), f parciálisan differenciálható u-ban.

R, u ∈ int Dom(f), f parciálisan differenciálható u-ban.

- Ha u-ban f-nek (lokális) szélsőértéke van, akkor

U.is: minden i-re az i-edik parciális függvénynek szélsőértéke van ui-ben, így az egyváltozós Fermat-tétel miatt ezeknek a deriváltja ui-ben 0, így a gradiens értéke 0.

Példa

Ennek gradiense:

Az

egyenletrendszer megoldásai: x = 0, y tetszőleges ill. y = 0 és x tetszőleges. A szélsőértékek helyei csak ezek közül kerülhetnek ki és ezek valóban szélsőértékek is, mert ezeken a függvény 0-t vesz fel, ami a lehetséges legkisebb értéke.

Magasabbrendű parciális deriváltak

Ha f parciálisan deriválható, akkor ∂1f és ∂2f szintén kétváltozós függvények (a pontonként a deriváltak, mint függvényértékek értelmezésével) és érdeklődhetünk ezek parciális differenciálhatóságuk iránt. Például:

És valóban:

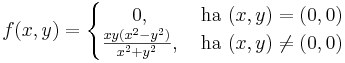

Tétel. (Young-tétel) Ha a másodrendű parciális deriváltak léteznek az u egy környezetében és folytonosak az u pontban, akkor az u-beli vegyes másodrendű parciláis deriváltak egyenlőek:

Azaz az alábbi, úgy nevezett Hesse-mátrix szimmetrikus:

Feladat. Az a kitétel, hogy az u-ban a másodrenrű parciláis deriváltak folytonosak, nem hagyható el, ugyanis. Legyen

Ekkor a 0-ban nem egyenlő a két vegyes parciális derivált.

Tekintsük a parciális deriváltakat:

Ehhez tehát elegendő kiszámítani a következő föggvényeket: y  (∂xf)(0,y), x

(∂xf)(0,y), x  (∂yf)(x,0). Ehhez a parciális deriváltak:

(∂yf)(x,0). Ehhez a parciális deriváltak:

Megjegyezzük, hogy a g=(∂xf,∂yf) függvény (0,0)-beli parciális deriváltjai nem lehetnek folytonosak, mert ott a függvény nem totálisan diffható. Ugyanis a g Jacobi-mátrixa:

ami a 90˚-os forgatás. Ekkor a g-t a (t,0) vektorral közelítve a 0-ba:

márpedig ha g minden parciális deriváltja folytonos lenne a (0,0)-ban, akkor g totálisan is deriválható lenne.

Többváltozós függvény szélsőértéke

Másodikderivált-próba

Kétszer differenciálható függvényre vonatkozóan megfogalmazhatjuk a lokális maximum és minimum létezésének elégséges feltételét. Csak a kétváltozós függvényekkel foglalkozunk. Tegyük fel, hogy grad f(u) = 0 és Hf(u) az f Hesse-mátrixa

- ha det Hf(u) > 0 és ∂11f(u) < 0, akkor f-nek u-ban maximuma van

- ha det Hf(u) > 0 és ∂11f(u) > 0, akkor f-nek u-ban minimuma van

- ha det Hf(u) < 0, akkor f-nek biztosan nincs szélsőértéke, ún. nyeregpontja van

- ha det Hf(u) = 0, akkor a próba nem járt sikerrel, azaz további vizsgálatokat igényel annak eldöntése, hogy u szélsőérték hely-e.

Megjegyzések. Mivel kétváltozós esetben

ezért olyan eset nem létezik, hogy det Hf(u) > 0 és ∂11f(u) = 0.

Világos, hogy a második derivált tipikusan azoknál a függvényeknél jár sikerrel, melyeket egy másodfokú függvény közelít a legjobban (aszimptotikusan másodfokúak). Ha a függvény ennél magasabb fokú, akkor a második deriváltak eltűnnek és a Hesse-mártix elfajul (vagy legalább is tipikusan elfajul).

Ha tehát

, akkor

, akkor  ,

,

és így a tipikus példák a következők.

Példák

1. Ha B kicsi, azaz az AC-hez képest kis abszolútrétékű szám, akkor a szélsőérték irányába mozdul el a feladat.

Ekkor grad f = ( 2x + y , 2y + x ) és

azaz 4 - 1 = 3 > 0 és 2 > 0 miatt minimum.

2. Ha |B| nagy (azaz AC-hez képest nagy), akkor a bizonyosan nemszélsőérték irányába.

Ekkor grad f = ( 2x + -3y , 2y + -3x ) és

azaz 4 - 9 = -5 < 0 miatt nincs szélsőérték: nyeregpont.

3. Negatív A és C-re és kis B-re:

Ekkor grad f = ( -2x + 3y , -2y + 3x ) és

azaz 4 - 1 = 3 > 0 és -2 < 0 miatt maximum.

4. Ha A és C előjele ellenkező, akkor rögtön következik, hogy nincs sz.é.

Ekkor grad f = ( 2x + y , -2y + x ) és

azaz -4 - 1 = -5 < 0 azaz nyeregpont.

5. Atipikus eset, ha AC = B2. Ekkor nem jár sikerrel a próba:

Ekkor grad f = ( 2x + 2y , 2y + 2x ) és

azaz 4 - 4 = 0, azaz határozatlan eset. De tudjuk, hogy

ami pontosan akkor minimális, ha x = -y, azaz ezeken a helyeken van szélsőérték.

6.

7.

| pótló gyakorlat | 5. gyakorlat |

![f(x,y)=\sqrt[3]{x^4+y^4}](/upload/math/2/c/3/2c335aa3afa0bf0f307a9be26d78c087.png)

![\lim\limits_{t\to 0}\frac{f(u+te)-f(u)}{t}=\partial_{e}f(u)=[\mathrm{grad}\,f(u)]\cdot e=[\nabla f(u)]\cdot e](/upload/math/6/8/f/68fffe8f513e9e456ec239b3c12e2069.png)

![\mathrm{J}^f(0,0)=[0, 0]\,](/upload/math/5/8/4/5844bda58422be338e9d02beef5b1e3e.png)